*目前只有一些Flux默认流程是支持的,很多自定义checkpoint等不兼容,所以测试下来高度指定风格不是很好用

模型下载与配置说明

模型下载地址

40 系显卡下载

- 模型文件:

svdq-int4-flux.1-dev - 放到...\ComfyUI-aki-v2\ComfyUI\models\diffusion\_models

依赖(车轮)

- Nunchaku 库下载

根据自己的 PyTorch 版本 下载,并放到路径:...\ComfyUI-aki-v2\python

Nunchaku FLUX DiT Loader参数说明表:

| 参数名 | 功能说明 | 典型/推荐值 | 备注 |

|---|---|---|---|

| cache\_threshold | 控制首块缓存容差,类似于 WaveSpeed 的 residual_diff_threshold。提高速度但可能降低质量。 | 0.12(典型值),0(禁用) | 增大数值 → 提速,可能损失质量 |

| attention | 定义注意力实现方法。 | nunchaku-fp16 | 比 flash-attention2 快约 1.2 倍;Turing(20 系)必须用 nunchaku-fp16 |

| cpu_offload | 启用 Transformer 模型的 CPU 卸载功能。减少显存占用,可能降低速度。 | auto | >14GiB 显存 → 禁用;≤14GiB → 启用 |

| device_id | 指定运行模型的 GPU ID。 | 根据实际 GPU 设定 | — |

| data_type | 定义反量化张量的数据类型。 | bfloat16(推荐) | Turing(20 系)不支持 bfloat16,只能用 float16 |

| i2f_mode | Turing(20 系) GPU 的 GEMM 实现模式。 | enabled / always | 仅 20 系有效,其他架构会忽略 |

测试:

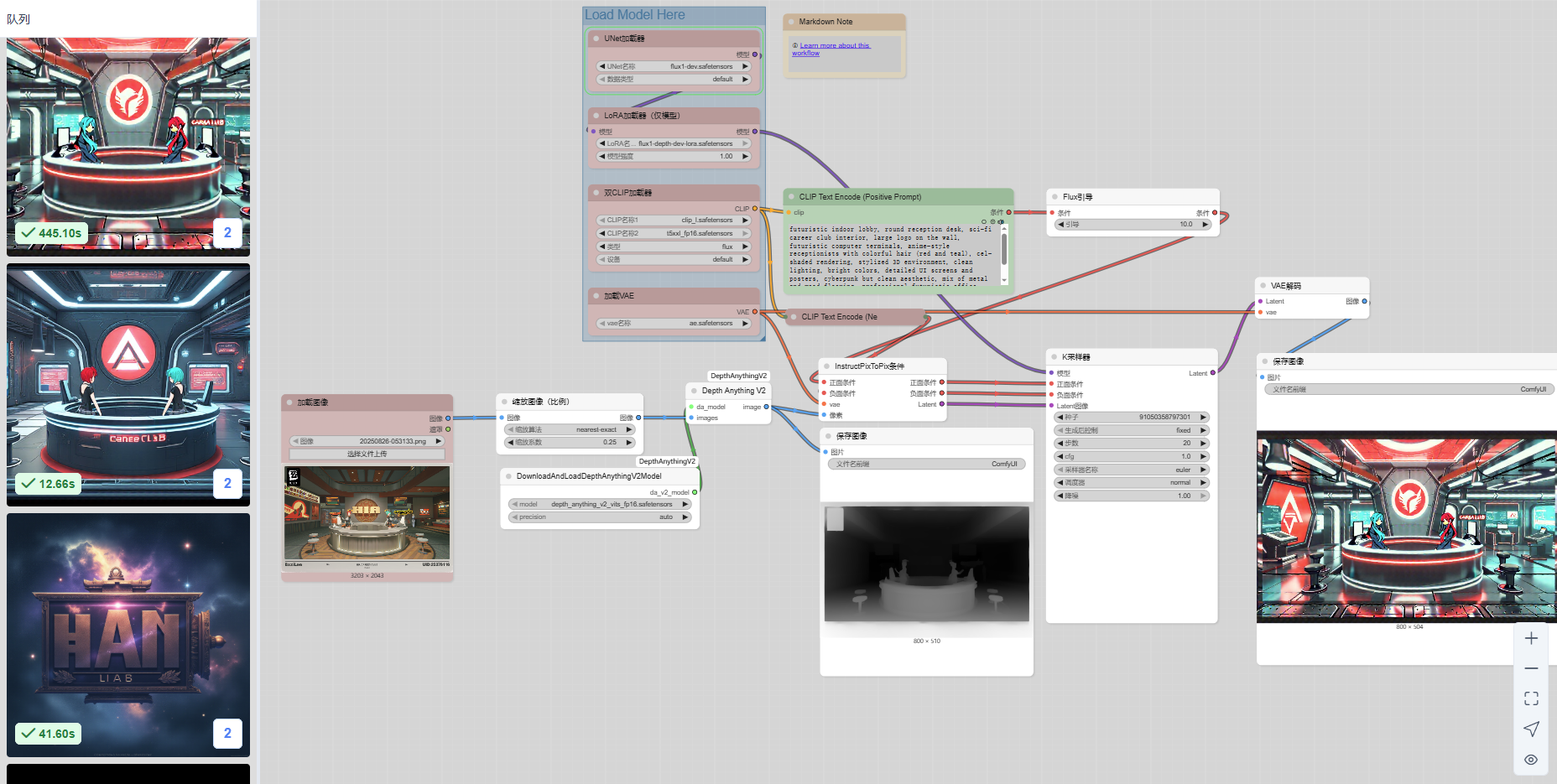

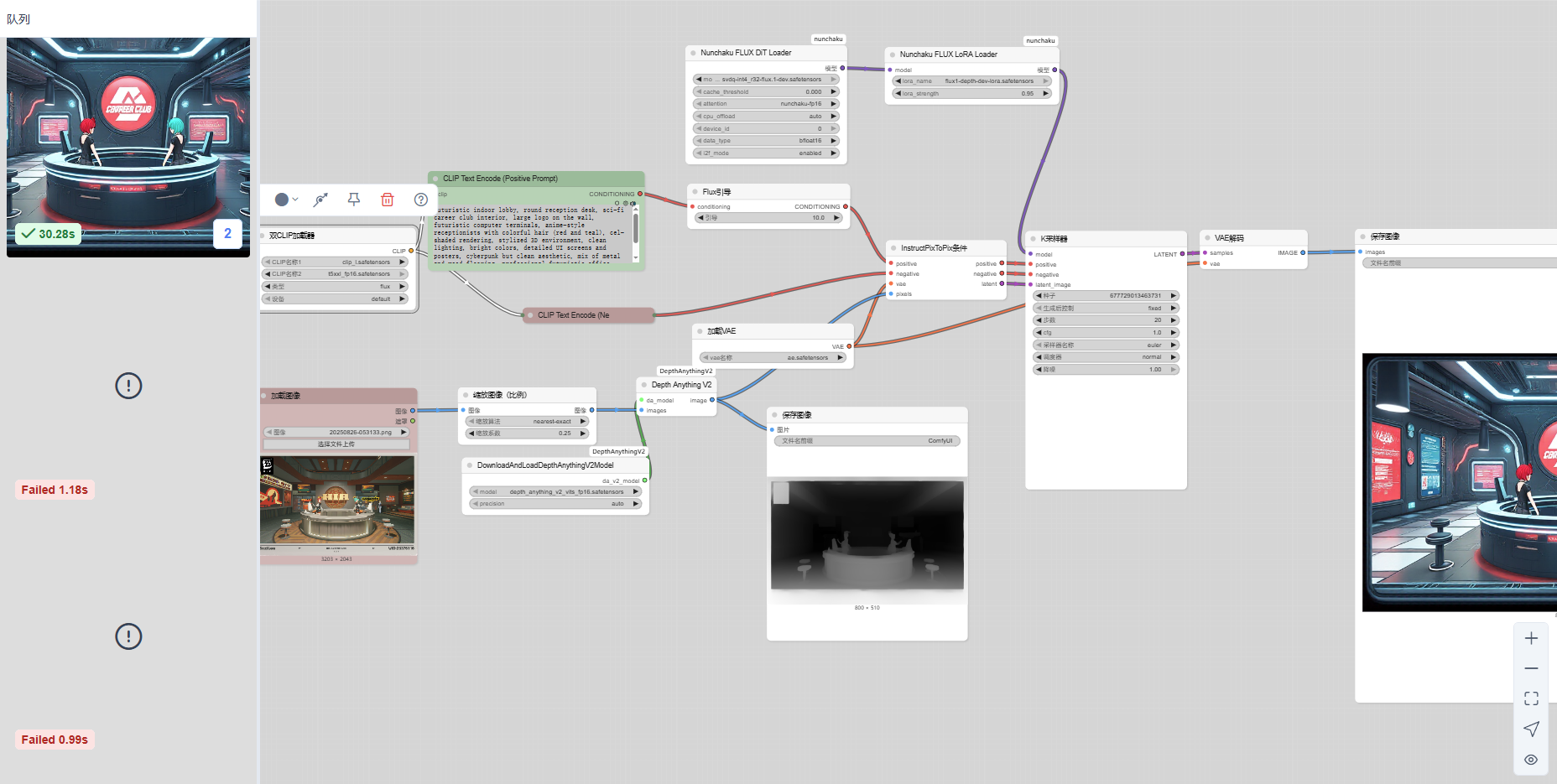

ComfyUI Nunchaku 与传统 Flux 在相同 K 采样器下的性能对比

在相同的 K 采样器 条件下,分别测试了 Nunchaku(depth) 与 传统 Flux(depth) 的运行日志。以下是关键日志输出与性能对比。

测试环境信息

- GPU: NVIDIA GeForce RTX 4060 Ti

- 显存: 16GB (16379.375 MiB)

- 框架: PyTorch 2.8

- 任务: depth 模型推理

Nunchaku(depth)日志

got prompt GPU 0 (NVIDIA GeForce RTX 4060 Ti) Memory: 16379.375 MiB VRAM > 14GiB, disabling CPU offload

[2025-09-22 16:00:13.722] [info] Initializing QuantizedFluxModel on device 0

[2025-09-22 16:00:13.812] [info] Loading partial weights from pytorch

[2025-09-22 16:00:26.519] [info] Done. Injecting quantized module

[2025-09-22 16:00:27.013] [info] Set attention implementation to nunchaku-fp16

model_type FLUX

Requested to load Flux loaded completely 7184.319969940186 122.3087158203125 True

Expand the shape of module x_embedder from (3072, 64) to (3072, 128)

Update in_channels from 64 to 128

[2025-09-22 16:00:34.136] [info] Loading partial weights from pytorch

[2025-09-22 16:00:34.807] [info] Done.

Requested to load AutoencodingEngine loaded completely 4967.662322998047 159.87335777282715 True

Prompt executed in 30.28 seconds

✅ 特点

- 使用 量化 Flux 模型(QuantizedFluxModel)。

- 自动扩展

x_embedder输入通道。 - 全流程加载完成,执行时间 30.28s。

传统 Flux(depth)日志

got prompt Loading model from: E:\AI\ComfyUI-aki-v2\ComfyUI\models\depthanything\depth_anything_v2_vits_fp16.safetensors

using MLP layer as FFN

loaded partially 5825.399761962891 5824.9755859375 0

Requested to load AutoencodingEngine loaded completely 191.70083618164062 159.87335777282715 True

Requested to load Flux loaded completely 547.2099178314209 122.6837158203125 True

E:\AI\ComfyUI-aki-v2\python\Lib\site-packages\nunchaku\utils.py:47: UserWarning: Using a non-tuple sequence for multidimensional indexing is deprecated

...

Prompt executed in 12.66 seconds

got prompt model weight dtype torch.float16, manual cast: None

model_type FLUX

Requested to load Flux loaded partially 5825.475918579102 5824.2032470703125 522

Requested to load AutoencodingEngine loaded completely 266.9465637207031 159.87335777282715 True

Prompt executed in 445.57 seconds

特点

- 直接从

safetensors加载,未进行量化优化。 - 存在 PyTorch 2.9 API 兼容性警告。

执行时间差异较大:

- 12.66s(部分场景)

- 445.57s(完整流程)

性能对比

| 模型类型 | 加载模式 | 执行时间(Prompt) |

|---|---|---|

| Nunchaku(depth) | 量化 + 模块扩展优化 | 30.28s |

| 传统 Flux(depth) | Safetensors (未量化) | 12.66s / 445.57s |

结论

通过对比可见:

- Nunchaku 在加载与运行过程中,依赖量化与模块调整,保证了模型在 显存占用与兼容性 上更具优势,整体运行稳定,性能表现均衡。

- 传统 Flux 在小规模推理时看似更快(12.66s),但在完整流程下耗时极长(445.57s),说明其在 复杂场景与长链路推理 下存在明显瓶颈。

👉 结论:在 深度推理任务(depth) 场景中,Nunchaku 方案更适合实际部署,兼顾速度与稳定性。

遇到的鬼畜问题:

一开始使用默认的nanchaku深度工作流会出现报错,

加载到Nunchaku FLUX DiT Loader就...

!!! Exception during processing !!!

CUDA error: out of memory

(at C:\Users\muyangl\actions-runner\_work\nunchaku\nunchaku\src\Tensor.h:95)

然后运行了一次另一个默认工作流:nunchaku-flux.1-dev

就莫名其妙好了..

原因未知

参考安装流程: